关于双臂机器人的主动式双摄像头和RGBD视觉系统标定法外文翻译资料

2022-11-08 20:46:03

英语原文共 6 页,剩余内容已隐藏,支付完成后下载完整资料

关于双臂机器人的主动式双摄像头和RGBD视觉系统标定法

作者:Aamir·Khan,Gerardo·Aragon·Camarasa, Li Sun, J.Paul·Siebert

译者注:除Li Sun先生来自于伯明翰大学的智能机器人实验室外,其他三位作者均来自于格拉斯哥大学的计算科学学院。

摘要——本文描述了一种将主动式双摄像头集成在双臂机器人内的摄像头手眼标定方法。为此,我们为我们的主动式机械人头部推导出了正向运动学模型,并且描述了我们用于标定和集成机器人头部的方法。这种刚性的标定法提供了一种闭环的手眼解决方案。之后我们还展示出了一种参数更新方法,这种方法可以用于动态地更新摄像头外部参数以获得最优的3D重建,此方法意义在于3D重建是机器人完成一些任务的基础,例如抓取和操作一些刚性无法形变的物件。实验数据显示,在重建当前场景3D结构的同时,我们的机器人头部还可以在总体上达到低于0.3毫米误差的一个亚毫米级精准度。以外,我们报告了如今流行的RGBD摄像头和我们双臂机器人测试台内部的主动式立体头部的对比性研究,此研究报告证明了我们提出的方法的精准性和可移植性。

- 引入

RGBD相机传感器(例如,类Kinect相机)之所以对机器人学以及机器视觉的研究带来了冲击,是因为他们提供了一种低成本,即用型且现成的传感器以适应不同的机器人配置,设置和任务。然而,RGBD相机传感器的精准度会因成像物体和传感器间距离的不同而改变[1]。也就是说,RGBD相机传感器限制了机器人的感知能力,因为它们提供的是低分辨率的深度图并且常常受到图像噪声的干扰。同样,他们的刚性结构不允许机器人调整相机的物理结构以从不同的距离对物件进行成像来获得高的精准度。这些限制使得表征给定物件的3D结构变得具有挑战性。

摄影测量视觉系统提供了符合要求的精度,但是成本过高。为了缓和高成本但又不损失精准度,我们在FP7 CloPeMa项目下,设计出了一种结合了工业双臂Yakasawa机器人原件的主动式双摄像头机器人头部系统。这个机器人头部能够在计算机的控制下改变它的注视点。因为它提供高分辨率成像用于3D映射和范围感测的能力,我们的机器人头部已经被成功地用于衣服感知和操作研究。到期到机器人头部瞄准不同部分的能力一个场景,需要保持其精确校准相对于机器人的内在和外在参数参考范围。由于机器人头部需要能瞄准同一场景内不同部分,这要求相对于机器人的参考坐标系必须保持内外部参数的精准标定。

本文中,我们不仅描述了我们用于矫正主动式机器人头部的方法,我们还描述了用以动态更新相机外部参数的高级解决方案,此方案为了实现相对于机器人正向运动链的几何兼容性。最后,我们提供了当分别集成在机器人运动结构中时,我们的机器人头部和RGBD相机的比较性评估。

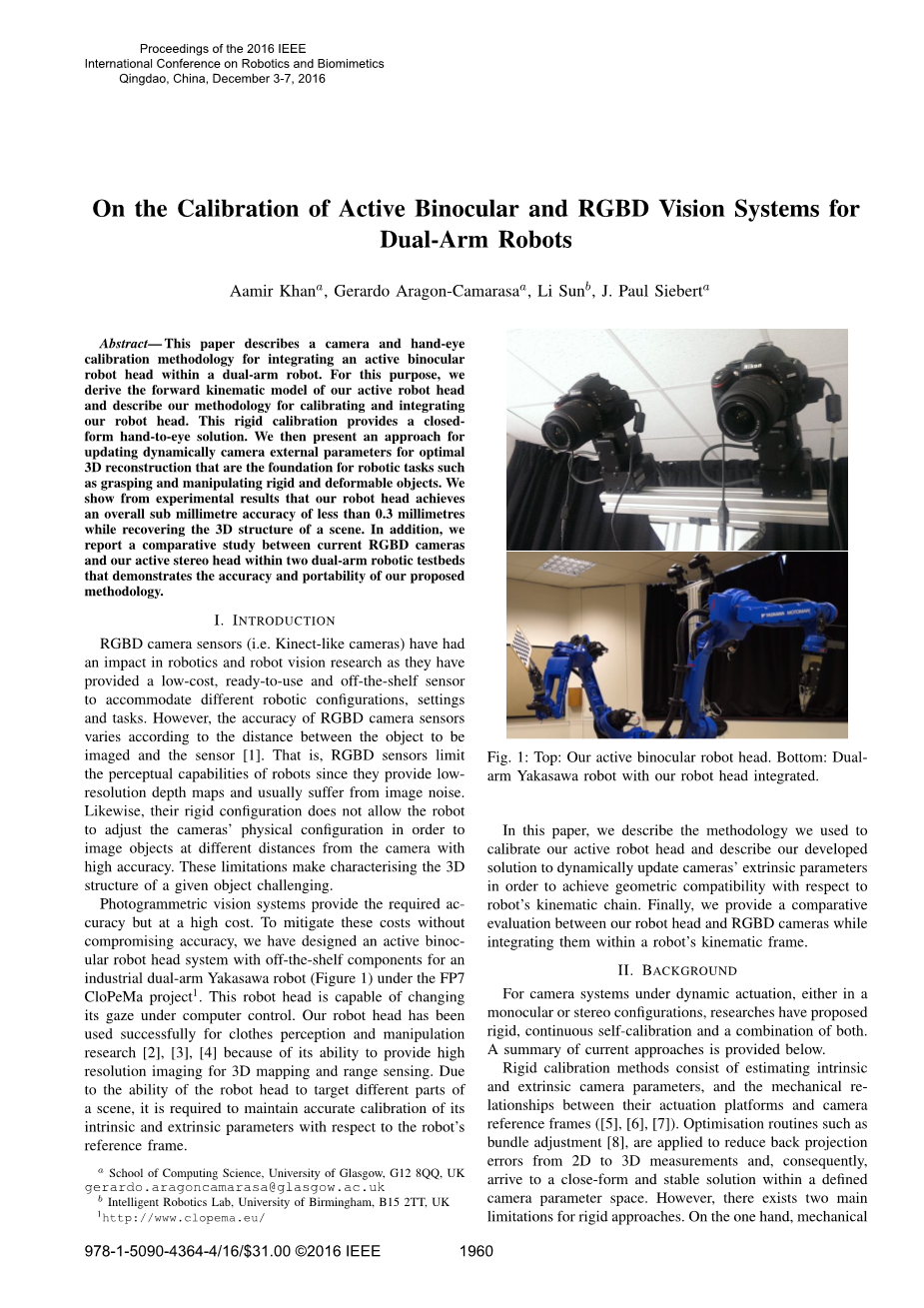

图1(a)主动式双摄像头机器人头部 图1(b) 集成了机器人头部的双臂Yakasawa机器人

- 背景

对于动态驱动下的相机系统,无论在单摄像头或者在立体式配置的情况下,研究人员都会提出刚性,连续的自校准和两者的结合。以下提供了当前方法的总结。

刚性标定发达包括评估内外部相机参数,驱动平台和相机参考坐标系间的机械关系([5],[6],[7])。例如光束法平差等的最优化路线被用于降低从2D到3D测量产生的反射误差,因此在被定义的相机参数空间中,得到了一个近似且稳定的解。然而,刚性方法存在着两个主要的局限。一方面,机械磨损并没有被考虑到,所以在标定法运作时,所获得的解取决于机械部分的质量如何。在另一方面,制动器接头间的距离和朝向必须被精确地测量出来。因此,由测量设备产生的误差和设备运行时的机械间隙也没有被带入计算。

PTU相机系统的自标定法已经广泛地研究了近20年且仍然是一个活跃的研究领域。不过,还没有一种通用且普遍的解被发明。比如,自标定法已经将解限定在了每个摄像机一个自由度[9],或者每个相机的个体偏航移动加上头的颈关节移动[10]。增加自由度将会导致重建场景时更低的精准度[11]。为了解决系统运动学中的限制,混合方法包括使用刚性解来初始化标定参数,然后在与环境交互时,更新内外部相机参数。这些方法是基于粒子滤波技术,用以更新在世界坐标系内的相机位置和相机外部朝向的[12]。由于我们的机器人也需要抓握高度可变形的物件,这些方法只能获得总体在0.5cm至1cm间的精度使得它们在准确度和精读上有所不足。

为了解决以上提及的限制,我们提出了一种在可见场景内处理动态内容的混合方法。我们的方法由简练但鲁棒的技术组成。我们必须指出的是我们并非企图解决自标定的一般性问题,但是我们提供了一种鲁棒且通用的方法来处理可形变与不可形变的物件。我们因此假设我们的视觉系统无需改变焦点,且我们已经完成了各个相机的焦距、光圈和快门设置的调节以获取期望的聚焦范围。

- 选材

- RGBD相机

- 华硕 Xtion Pro:华硕 Xtion Pro是一种使用了深度感知技术的RGBD相机。它是基于机构光的,且拥有0.8至3.5m的深度范围,640x480的3D点云分辨率,1280x1024的RGB图像分辨率,30fps的帧速率和1.5帧的延迟。这种传感器的深度误差由于传感器和物件间距离的增加而降低。在校准好摄像头之后,它能在距离为0.96m时获取到最佳的4.7mm深度精度,当距离为3.6m时精度将降到38.6mm[14]。

- Kinect V2: 由微软开发的Kinect v2也是一种RGBD-D相机,它基于的是飞行时间技术。它拥有0.5至4.5m的深度范围,512x424的3D分辨率,1920x1080的RGB分辨率,30fps的帧速率和20ms的延迟。与华硕Xtion Pro相似的是,Kinect V2传感器的深度误差也根据传感器和物件间的距离减小。很明显的可以看出,此传感器得到的距离测量要比华硕Xtion Pro精准的多。然而Kinect V2的重建误差在距离为3m时大约为20mm[15]。

- 主动式双摄像头机器人头

对于我们的主动式双摄像头机器人头,我们采用了相对便宜且市场上可供的原件使我们可以获得高质量的3D深度图和用于可形变物件识别[2]和操纵[3]的密集点云。因此,我们的机器人头部包含两个每400ms获取1600万像素的成品Nikon DSLR 相机(D5100)。两个相机都被安装在拥有两个自由度的云台平台(PTU-D46)上。相机被用于光学立体采集而预定义的底线严格分隔开。我们将主动性机器人头部与计算机相连,计算机的核心为Intel Core i7-3930K,RAM32GB,运行Ubuntu和ROS系统。

图1描述了装配在双臂机器人上的机器人头部。主动式机器人头的视觉能力包括:自动聚焦控制和基于SIFT特征的视觉搜索。为实现实时性能,我们使用了SIFT的一种GPU变体。GPU-SIFT特征被用于取相机边缘和动态标定路线场景中的特征追踪(详见IV部分中的D节)。同样,我们使用立体匹配器的一种GPU版本来计算从机器人头采集的两张图像的垂直和水平差异。因此,我们的机器人头可以在0.2fps产生16MP的深度图和点云。

- 机器人

在本文中,我们在两个不同的机器人测试台上评估这种高级的标定方法。第一种测试台是由YASKAWA Motoman制造的双臂工业机器人,如图1所示。这个机器人测试台由两个MA1400操作器和一个定做的转盘组成。每条手臂有6各自由度,还有如下特征参数:4kg最大载重、1.4m的最大触及距离还有plusmn;0.08mm的精准度。这个双臂机器人由DX100控制器供电和控制。我们的主动式双摄像头机器人头部被牢牢地安装在转盘上,位于两只机器手之间。

第二个测试台是Rethink Baxter机器人(图二)。Baxter是一个拥有两支七自由度手臂和最先进感知技术的人形拟人机器人。它的主要任务是能够操作在人类环境中持续运行并运行尽量长的时间段。Baxter的位置精度是plusmn;5mm还有1.2m的最大触及距离。

图2:Rethink Baxter机器人正握着标定目标。在我们的试验中,我们将RGBD相机(图中为Kinect V2)放置在机器人的头顶

- 方法

为了在动态相机移动中获得度量上精准的深度图,我们采取了一种混合方法。那就是,我们首先采用刚性相机标定程序来获取内外部相机参数,然后我们找到机器人和标定目标以及机器人头和机器人之间严格的欧几里得变换(分别详见IV部分的B节和C节)。动态的在线转向标定包括跟踪从先前的相机姿态观察到的兴趣点特征已知的3D位置(详见IV部分的D节)。跟踪的特征然后依次用于更新相机外部参数。

图3:CLoPeMa 机器人头部HOME位置的坐标系

- 正向运动学推导

- 为了找到几何变换进行积分

- 我们的机器人头与机器人,我们最初需要推断

- 主动双目机器人的前向运动模型

- 头。

为了找到几何变换进行集成我们的机器人头与机器人,我们最初需要推断主动双目机器人头部的正向运动模型。图3描绘了机器人头部HOME位置的坐标系(图中H下标)。我们使用Sharkey等人[19]使用的标记表示我们的正向运动学模型。表格1定义了坐标系。我们假设世界参考系,{ W },位于机器人头部的基础,{ B },上,而且。Sharkey等人[19]设定如果相机瞄准{ W }内的同一点X,则各个摄像机的两个开放运动链将围绕X封闭。因此,从基点到目标位置开放运动链的正向运动为:

表I:坐标系定义

|

{W} |

世界坐标 |

|

{B} |

基点 |

|

{R} |

滚动坐标(不考虑) |

|

{P} |

转动坐标(不考虑) |

|

{CSR/L} |

相机分配(左/右)出发点为:(0,ycs0,zcs0) |

|

{ER/L} |

分别提升(左/右) |

|

{VL/R} |

朝向(左/右)出发点相对于{E}的坐标为:(0,yvo,zvo) |

|

{CL/R} |

自旋转(左/右)(不考虑) |

|

{OL/R} |

光学方向(左/右)出发点相对{C}或{V}为:(u,v,w) |

|

{T} |

目标物件。为了简化,两个中心点都由{W}中的一个点表示.出发点相对于ZOL/OR为dTL和dTR |

是相对坐标中机器人头部的基点, 是世界坐标系与目标坐标系间的转换,s 表征的是,如果相机分配为左边,那么s=1,如果是右边,s=-1。因此,公式1为左右两个相机都定义了正向运动链。

在实践中,上述的正向运动链不是封闭的,因为我们假设斜面参考系是与光学成像平台对齐的。在我们的机器人头部中,需要找到从斜面参考系到相机成像平面的主要点的几何转换,ETC ({E}和{C}分别如表I中的定义)。为了找到,我们首先需要进行相机标定来找到相机的固有几何形状,然后相机成像平面的主点如下所述。

- 相机标定

为了找到固有相机参数,我们使用OpenCV标定程序来对相机的参数空间进行采样,方法是在OpenCV检查目标的不同位置和不同方向进行检测。我们将校准目标和机器人抓手相连并使用双臂机器人自动化目标的采样过程。我们的机器人头部是和机器人空间中一个确定点交汇的,在相机校准的过程中,机器人头部依然保持着在此确定点。因此,我们对各个相机单独的进行校准,通过在不同位置和不同朝向展示标定目标以确保对相机参数空间足够的采样。

对于每一个采样目标的位置,OpenCV会返回相机相对与目标的位置。然而,我们发现通过使用稀疏的光束法平差对这些位置进行优化,我们可以得到比OpenCV立体标定程序更加准确的相机位置。因此,我们通过标定目标间的三角运动学变换可以发现相机之间的几何关系为

- 手眼标定

为了将机器人头部的运动链封闭,并且将机器人与头部整合,我们需要找到:

- 机器人抓手和标定目标间的变换-,

- 对于左右相机的从斜面坐标(E)到相机坐标(O)的变换-。

为了找到上述的变换,我们使用了蔡氏手眼标定[20]来作为ROS节点。因此,因此,对于 , 我们将左相机位姿和机器人与各个采样目标位置的正向运动链输入手眼校准程序,正如IV部分B节所述。需要注意的是,机器人的运动链是使用ROS统一机器人描述格式(URDF)定义的(http://wiki.ros.org/urdf ),我们用TF取回变换矩阵(http://wiki.ros.org/tf)。

通过获得

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[138677],资料为PDF文档或Word文档,PDF文档可免费转换为Word