融合激光雷达与图像信息的智能车辆环境感知系统设计毕业论文

2020-04-15 16:54:31

摘 要

随着汽车保有量的日益增多,交通安全问题日益凸显,智能车辆正成为汽车行业的研究热点。融合多传感器信息的环境感知系统为智能车辆的主动安全提供了保障,但是当前的环境感知系统性能普遍不够强,还不足以用于汽车的量产。

本文分析了各类视觉和雷达传感器的优缺点,然后选取了激光雷达和图像信息进行融合,利用KITTI数据集及其配套的开发工具包,使用Matlab进行算法评估,将雷达点云投影到图像并对三维目标进行了标记,最后分析了该算法对数据集的处理效果,发现其目标识别准确率较高,但运行时间较长,对于激光雷达与图像信息融合的算法还有一定的优化空间。

关键词:智能车辆,环境感知系统,数据融合,立体匹配,目标追踪

Design of Intelligent Vehicle Environment Perception System Combining Lidar and Image Information

Abstract

With the increasing number of automobiles, traffic safety issues have become increasingly prominent. Intelligent vehicles are becoming a research hotspot in the automotive industry. Multi-sensor information fusion environment-aware system provides guarantee for the active safety of intelligent vehicles, but the performance of current environment-aware system is generally not strong enough to be used in the production of vehicles. In this paper, the advantages and disadvantages of various kinds of vision and radar sensors are analyzed, and then the lidar and image information are fused. Using KITTI data set and its supporting development toolkit, the algorithm is evaluated by using matlab. The lidar point cloud is projected to the image and the three-dimensional target is marked. Finally, the processing effect of the algorithm on the data set is analyzed, and the target identification is found. The accuracy rate is higher, but the running time is longer. It is obvious that there is still a lot of room for optimization of the algorithm of lidar and image information fusion.

Key words:Intelligent vehicle, environment sensing system, data fusion, stereo matching, target tracking

目 录

摘 要 I

Abstract I

第一章. 绪论 1

1.1 背景及意义 1

1.2 智能车辆的国内外研究现状 1

1.3 KITTI数据集 3

1.4 本文的研究内容与章节安排 3

第二章. 智能车辆的环境感知系统设计 5

2.1 环境感知系统介绍 5

2.2 环境感知传感器 6

2.2.1 视觉传感器 7

2.2.2 雷达传感器 10

2.3 智能汽车环境感知系统的组成 15

2.3.1 环境感知系统的硬件组成 15

2.3.2 环境感知系统的软件组成 19

第三章. 环境感知系统的实现 20

3.1 传感器数据采集 20

3.1.1 图像采集 22

3.1.2 定位数据采集 22

3.1.3 激光雷达数据采集 22

3.2 传感器校准 24

3.2.1 同步 24

3.2.2 相机校准 25

3.2.3 激光雷达和定位系统(GPS/IMU)校准 26

3.3 地面实况 27

3.4 基准的选择 28

3.5 评价指标 29

第四章. 实验与分析 31

4.1 立体图像匹配 31

4.2 光流估测 32

4.3 视觉测距/SLAM 33

4.4 MATLAB实验 33

4.4.1 雷达点云投射到相机图像 36

4.4.2 二维和三维物体边框标注 38

第五章. 总结与展望 40

5.1 总结 40

5.2 展望 40

参考文献 41

致谢 43

绪论

背景及意义

汽车出行已成为人们出行的重要选择之一,随着汽车工业的快速发展,汽车数量迅速增加,汽车安全问题也越来越受到重视[1]。根据大量的交通事故报告可以发现,交通事故发生的原因包括超载,超速,不规范驾驶车辆以及驾驶员的注意力没有集中等。事实证明,如果司机能够提前发现险情,并及时采取减速,制动,转向等措施,相当一部分交通事故是可以避免的[2]。为了解决这些问题,从最后一个原因切入,智能车辆的主动安全成为研究热点。

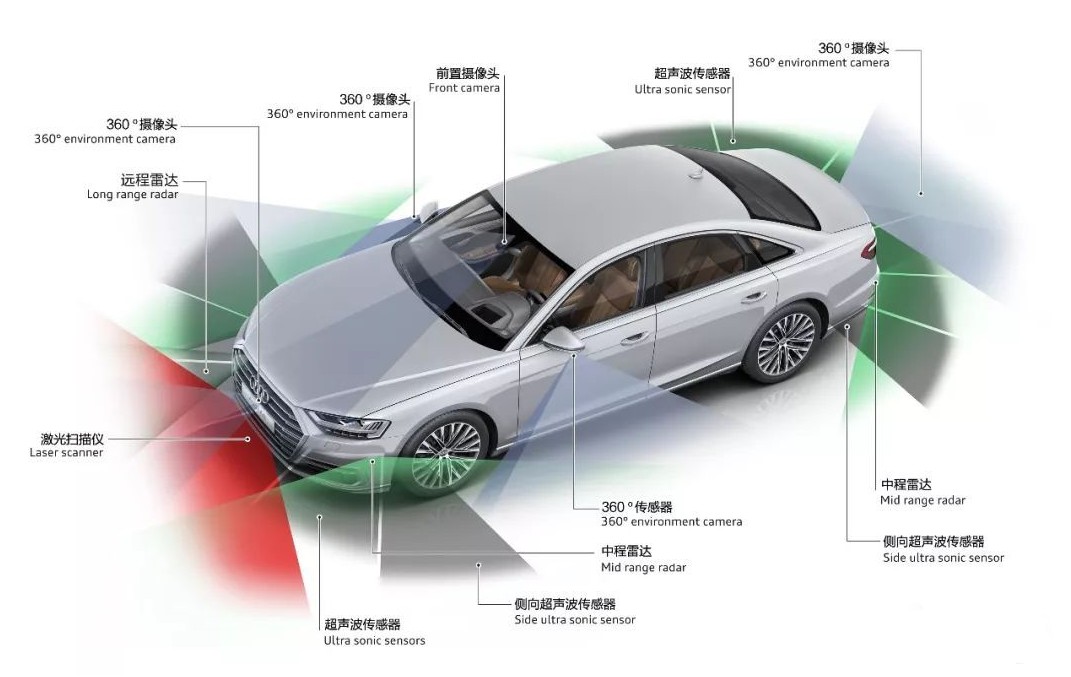

智能驾驶的核心是模拟驾驶员对环境感知,决策和执行过程的理解和学习。作为智能驾驶的最关键的环节之一,环境感知系统就是要学习人类对周围环境的感知方法来分析处理周围的环境信息。安装在车辆上的各种类型的环境感知传感器为环境感知系统提供了大量数据,但是这些数据包含了许多与驾驶不相关的信息。全面准确地理解周围复杂的环境信息是人类视觉的一大显著特点,人类的感知系统区别于传统传感系统的一点在于人类可以选择性的感知周围的环境,例如在驾驶车辆时,驾驶员会尽量选择关注只与驾驶车辆相关的信息,专注于驾驶;同时,对于目标的关注,人类会优先关注靠的近的,体积大的,运动着的或是与周围环境有较大差异的对象[3]。对于计算机来说,传感器就是它的眼睛,通过人为设置的参数来获得由各种传感器获取的场景数据从而理解场景语义。如果环境感知系统可以学习人类有选择地处理周围环境信息,那么对于计算机来说,其计算量将大幅下降,处理速度也将更快。目前,自主车通过对道路场景低层的语义理解已经实现了自主导航与定位,但在未来,只有通过对道路场景进行全面的理解,自主车或其他智能设备才能与场景进行更为复杂的交互[4]。

智能车辆的国内外研究现状

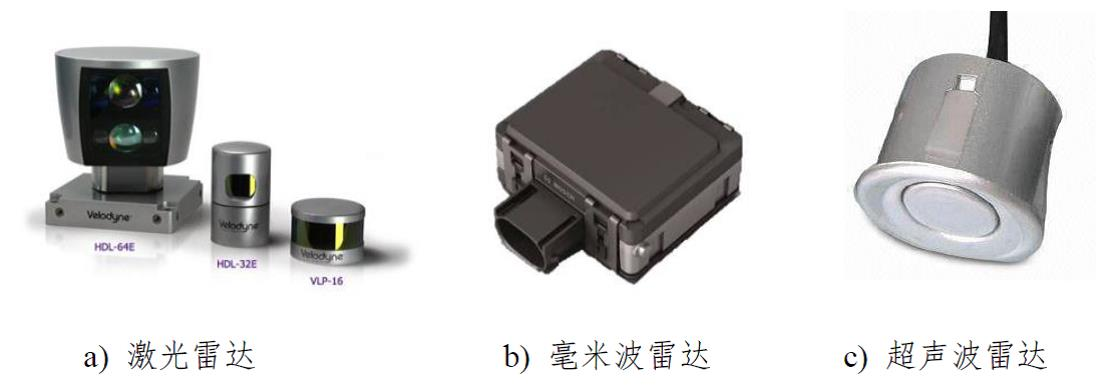

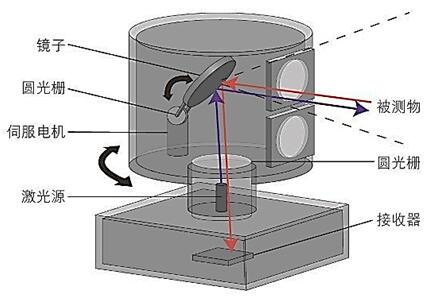

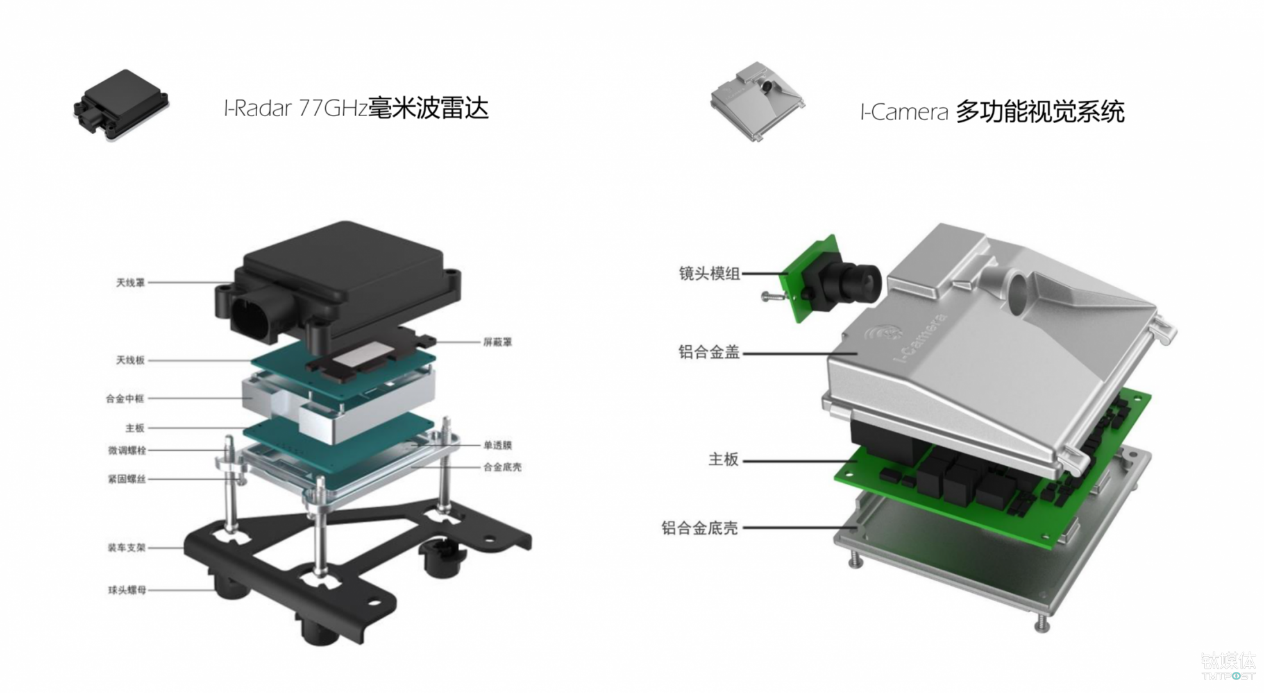

国际上,上世纪七十年代,美国成为最早研究智能车辆(无人驾驶汽车)的国家之一,并成为当今智能车辆领域的领导者[5];九十年代以后,随着环境感知和计算机技术的发展,车辆辅助驾驶系统的研究实现了跨越式发展[6-8]。卡耐基梅隆大学研发出Boss无人车的环境感知系统,该系统主要由两个工业相机、一个64线激光雷达、六个单线雷达和四个毫米波雷达组成,通过将多传感器获得的信息进行融合处理,实时的得出车辆周围环境信息[9]。德国Universitat der Bundeswehr团队的MuCAR-3通过车顶的64线激光雷达和车内的双目相机提供环境信息。英国牛津大学与2011年公开展示的第一辆无人驾驶汽车Wildcat,通过车顶的工业相机和激光雷达组成感知系统,收集环境信息的同时及时作出决策进行车辆导航,成功通过测试[10-12]。英国的牛津大学改装了一辆越野型无人驾驶汽车,该车在行驶中可以不用GPS,而是采取激光雷达感知道路情况,可以在山路中正常行驶[13]。意大利帕尔马大学VisLab主要开发机器视觉算法和智能系统在汽车领域的使用,该团队的特点在于他们的环境感知方案放弃了热门的雷达组合系统而仅采用机器视觉技术[14]。其在2014年3月底推出的无人驾驶汽车Deeva配备了超过二十台相机和四台毫米波雷达,然而外形与普通汽车相似[15]。2014年,谷歌向全世界发布了最新的无人驾驶原型车,该车顶装有激光雷达,能够清晰扫描半径 200 英尺(约为 60.96m)内的道路情况、实时绘制出立体地图,并准确识别出道路两旁和上方的交通标志;车辆左后轮上安装有里程计,可以估算车辆移动距离,辅助进行车辆定位;车头车尾装有雷达感应器,用以对车辆周围障碍物进行检测,该汽车搭载的无人驾驶系统已经率先达到业内领先的Level 4级别[16]。而特斯拉更是将已经带有Autopilot(自动驾驶)功能的车型进行量产并收获全球数以万计的订单。

在国内,智能车辆发展还相对落后,为了提高智能车辆的水平,减少交通事故的发生,中国近年来逐步加大了对车辆辅助驾驶系统的投入,但是由于中国起步较晚,基础也比较差,因此还需要一定时间才能达到世界主要发达国家的技术水平[17-18]。我国“八五”期间,由包括清华大学、浙江大学等多所国内大学联合开发的ATB-1系统安装主要有彩色相机、陀螺仪、超声波雷达等传感器,计算机系统采用两台SunSpark 10完成信息融合、黑板调度、全局和局部路径规划任务,在结构化和非结构化地形行驶中展现了良好的障碍检测和道路跟踪能力[19]。“九五”期间,我国继续研发的ATB-2系统在ATB-1系统的基础上增加了夜间行驶的能力,试验表明在低速状态下试验车可以有效地对夜晚非结构地形的障碍物进行检测并进行路径规划[19]。2003年清华大学推出了智能车THMR-V(Tsing Hua Mobile Robot5),该款智能车采用分层架构,车上安装有激光雷达、工业相机、高精度GPS等多种传感器,除外部环境信息外,还可以采集车身位姿、油门和刹车等多个信号,2006年还研制出可以分为高速和城区两种环境下不同驾驶模式的无人驾驶汽车,其最高时速为100 km/h[20]。2011年,一汽集团和国防科技大学于2006年开始合作开发的产物——红旗HQ3,首次完成总长两百多公里的高速无人驾驶试验,整个过程中平均车速超过80km/h[21]。2016年,百度也发布了其自动驾驶解决方案,它的无人车在车顶搭载了三个环绕车顶的16线激光雷达、一个64线激光雷达以及两个工业相机,另外还在车辆前部安装有毫米波雷达,由此组成其环境感知系统。北京初创公司驭势科技推出的解决方案则是通过双目立体相机进行路况探测,然后和多线激光雷达协同得出高精度的周围环境数据,由此可以看出多传感器融合的环境感知方案已经得到了智能汽车领域的广泛认可[22]。

KITTI数据集

KITTI数据集由KIT(Karlsruher Institut für Technologie,卡尔斯鲁厄理工学院)和TTI-C(Toyota Technological Institute-Chicago,芝加哥丰田技术学院)联合支持,是世界上最大的自动驾驶场景数据集之一[23]。该数据集用于评估计算机视觉技术在车载环境下的性能,例如车辆环境中的stereo(立体图像),optical flow(光流),visual odometry(视觉测距),3D object detection(3D物体检测)和3D tracking(3D跟踪)[23]。KITTI数据集包含来自城市,乡村和高速公路等场景的真实环境的图像数据,并且每个图像最多可以达到15辆车和30名行人,以及不同程度的遮挡和截断[23],整个数据集以10 Hz采样和同步[24],其内容包括389对立体图像和光流图,39.2 公里的视觉测距序列还有超过20万3D标记物体的图像[24]。这些原始数据集分为道路(Road)、城市(City)、住宅(Residential)、校园(Campus)和人(Person)。对于3D物体检测,标签(label)细分为汽车(car)、货车(van)、卡车(truck)、行人(pedestrian)、坐着的人(sitting pedestrian)、骑行者(cyclist)、有轨电车(tram)和其他(misc)[25]。

本文的研究内容与章节安排

本文通过了解国内外智能车辆环境感知系统的发展现状,研究了各类视觉和雷达传感器的工作特性,比较了多种传感器组合方案和融合方法,并选择了KITTI数据集进行研究和实验。

以上是毕业论文大纲或资料介绍,该课题完整毕业论文、开题报告、任务书、程序设计、图纸设计等资料请添加微信获取,微信号:bysjorg。

相关图片展示: