基于灰度像素的中文图像文字识别外文翻译资料

2021-12-23 22:46:58

英语原文共 5 页

基于灰度像素的中文图像文字识别

白金峰,陈智能,白兰峰,徐波

互动数字媒体技术研究中心,

中国科学院自动化研究所,北京100190

{jinfeng.bai,zhineng.chen,bailan.feng,xubo} @ aia.ac.cn

摘要

本文在图像和视频的中文文本识别中提出了一种新方案。它与将二值化文本提供给OCR引擎并且获得认可结果的传统二值化文本图像范式不同。拟议的方案,名为基于灰度中文图像文本识别(gCITR),实现通过以下步骤直接识别灰度像素:图像文本过分割,建筑识别图,中文字符识别和光束搜索确定。 gCITR的优点在于:(1)它并不严重依赖于二值化的性能,在实际中也并不严重影响OCR的性能,(2)灰度图像保留更多文本的信息,从而便于识别。来自13个电视新闻视频的文本的实验结果证明了所提出的gCITR的有效性,从中观察到显著的性能增益。

索引术语 - 中文文本识别,图像文本,视频文字,灰度识别

1.导言

为了快速定位大量多媒体数据中感兴趣的内容,在基于内容的图像研究[1]和视频故事摘要[2,3]方面进行了大量的研究。图像中的文本信息,尤其是重叠文本,为图像中的高层次语义概括提供了更可靠的线索。虽然商业光学字符识别(OCR)系统已经达到了文档图像的高性能,图像或视频中文本的识别(例如叠加文本)仍然是挑战性问题,特别是对于中文文本识别。 这是一方面,具有相同大小的块空间的汉字的笔划数量变化很大; 在另一方面,涉及更大的类别集,因此需要管理类似角色之间的更多混淆。

由于商业OCR在图像文本识别中应用时由于背景复杂、分辨率低而导致性能差,因此开发了多种复杂的二值化算法,如[4,5,6]从复杂背景中提取文本。然而,二值化作为一个无监督的过程,在图像文本遭受诸如不均匀的光照、复杂的背景、模糊等多种退化时,是一个非常具有挑战性的问题。此外,显著的类内差异,即具有不同字体、不同大小的同一汉字,以及某些类别对之间的类间差异微妙,也是一个大而棘手的问题。因此,在字符识别步骤中,我们不再努力探索一种高性能的二值化算法,而是直接在灰度像素上识别图像文本,因为这是一个有监督的过程,更能处理问题。

中文图像文本识别的另一个挑战是分割(即将文本行的图像分割成与单个字符相对应的片段),因为相当一部分汉字是在左右两侧分离的结构中。此外,由于性能不佳的二值化算法导致的触摸字符也会导致更多的不正确提取字符,这些字符通常无法用当前使用的方法正确识别。为了解决这些问题,本文介绍了一种过度分割技术,该技术广泛应用于手写体汉字串识别[7,8]和英文文本识别[9]。它试图在文本行的图形表示中找到所有潜在的拆分点,然后尝试消除不正确的拆分点。

本文提出了一种基于二值化后图像垂直直方图的过度分割方法,用于生成潜在的分割点。在此基础上,利用分割点的几何信息建立了一个图形,并将字符识别模型应用于由两个连接顶点定义的每一个裁剪图像。然后,从起始点一步一步到结束点,进行了网格的建立和修剪的动态过程。在每个步骤中,根据不同的历史,每个识别结果都由一个3-gram语言模型[10]进行估计。同时,通过最大化识别分数和语言分数的线性组合上定义的目标函数来进行波束搜索,以找到最佳路径。最佳路径中对应拱门的字符将是识别结果。这不仅可以消除不适当的分割点,而且可以利用NBEST识别结果。因此,我们的方法对于复杂的背景、低分辨率或视频编码伪影尤其有效。对13个电视新闻视频文本的实验结果表明,该方法是有效的。与ABBYY FineReader[11]相比,性能显著提高,后者分别在第11[12,13]和第12[14]次强大的阅读竞争中用作基线系统。

论文的其余部分组织如下。我们将在第2节中讨论相关工作。在第3节中,详细说明了所提出的识别方案。第4节展示了实验配置和结果。这项工作最终在第5节中结束。

2.相关工作

在图文识别方面,第11届国际文献分析与识别会议(11,12,13),第12届国际文献分析与识别会议(12,14)上的两次稳健阅读竞赛对这一研究领域表现出了积极的兴趣。为了解决这个问题,人们提出了各种各样的算法。大致上可以分为两类:基于二值化的方法和基于整体方法的方法。基于二值化的方法(如Mishra[4]、Boris[6]等)致力于开发一种高性能的文本图像二值化算法,并将得到的图像反馈给商业OCR引擎,得到结果。基于整体方法的方法(如Zohra[9]、Yokobayashi[15]等)使用了过度分割和波束搜索结构来获得识别结果,因为英语单词中的触摸字符非常常见。近年来,后一种方法在图像文本识别中显示出了良好的性能。Yokobayashi等人[15]提出了两种自然场景图像的字符识别系统,该系统基于灰度字符图像的全局仿射变换(GAT)相关技术的改进版本修改了识别步骤。Zohra等人[9]提出了一种图像文本识别图,该图利用卷积神经网络对图像进行过度分割和字符识别。

在中文图像文本识别中,据我们所知,目前只报道了以前的方法[16,17]。一个重要的原因是,由于汉字的类别如此之大,人们可能找不到这么多有标签的数据来训练字符识别模型。以第十二届[18]国际文件分析与识别会议的离线汉字识别为例,分类总数为3755个,样本总数为110万左右。因此,能够克服这一挑战的方法将是一个更好的选择。

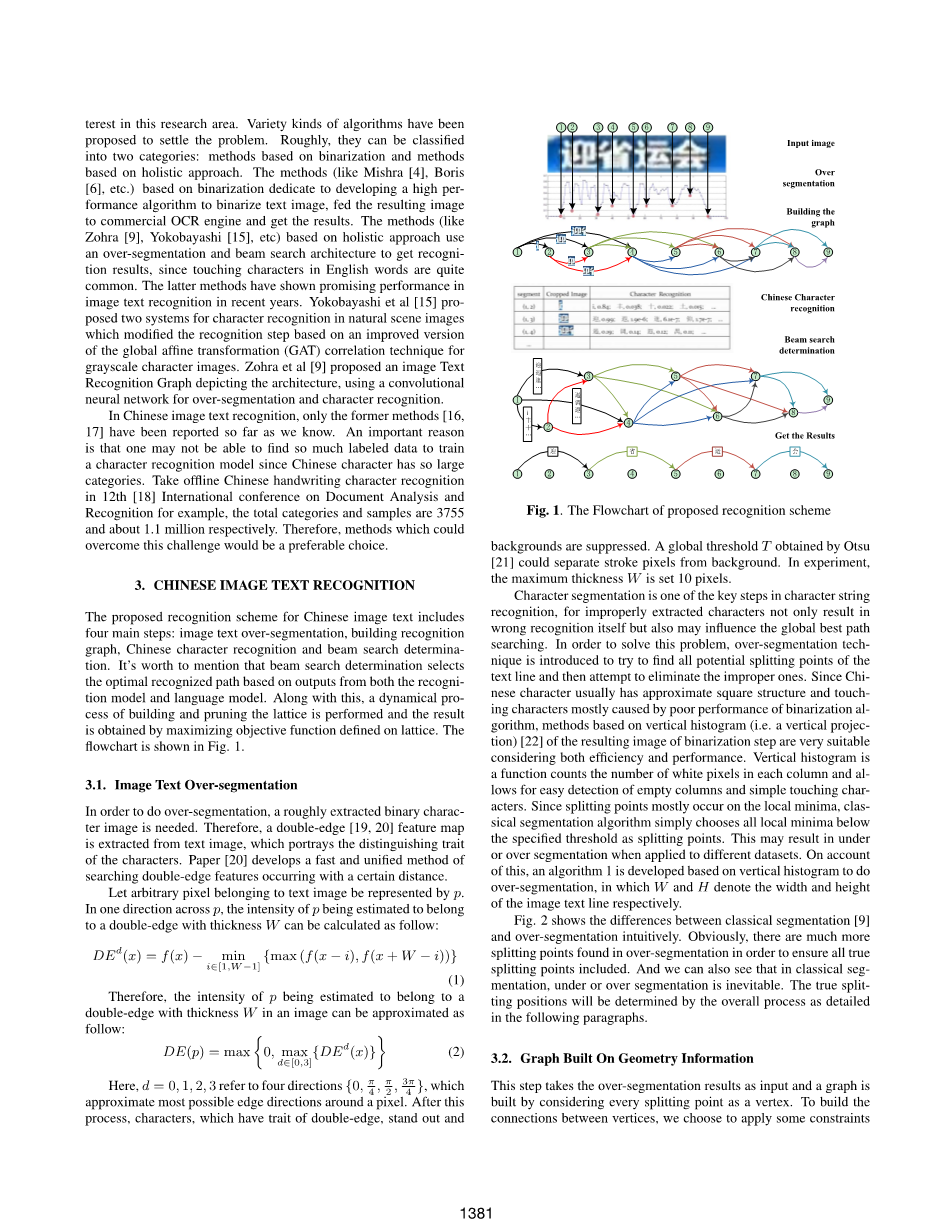

3.中文图文识别

提出的中文图像文本识别方案包括四个主要步骤:图像文本过分割、建立识别图、汉字识别和波束搜索确定。值得一提的是,波束搜索的确定是根据识别模型和语言模型的输出选择最优的识别路径。在此基础上,进行了网格的建立和修剪的动态过程,通过最大化网格上定义的目标函数得到了结果。流程图如图1所示。

3.1图像文本过度分割

为了进行过分割,需要一个粗略提取的二值字符图像。因此,从文本图像中提取出一个双边缘[19,20]特征图,描述了字符的特征。论文[20]发展了一种快速统一的搜索具有一定距离的双边缘特征的方法。

让属于文本图像的任意像素以p表示,在p的一个方向上,p的强度估计为一个厚度为w的双边,计算如下:

DEd(x) = f(x) minus; min iisin;[1,Wminus;1] {max (f(x minus; i), f(x W minus; i))} (1)

因此,估计P的强度属于图像中厚度为W的双边缘,可以近似如下:

DE(p) = max 0, max disin;[0,3] {DEd(x)} (2)

这里,d=0,1,2,3表示四个方向{0, pi;/ 4 , pi;/ 2 , 3pi;/ 4 },近似像素周围最可能的边缘方向。经过这一过程,具有双刃性、突出性和背景抑制性的人物形象得到了抑制。由otsu[21]获得的全局阈值T可以将笔画像素与背景分离。在实验中,最大厚度w设置为10个像素。

字符分割是字符串识别中的关键步骤之一,提取不当的字符不仅会导致错误的识别,而且会影响全局最优路径搜索。为了解决这一问题,本文引入了过分割技术,试图找到文本行中所有潜在的分割点,并试图消除不合适的分割点。由于汉字通常具有近似的方形结构,触摸字符主要是由于二值化算法性能差造成的,因此基于二值化步骤生成图像的垂直直方图(即垂直投影)[22]的方法在效率和性能上都非常适合。垂直柱状图是一个计算每列中白色像素数的函数,它允许轻松检测空列和简单的触摸字符。由于分割点主要发生在局部极小值上,传统的分割算法简单地选择低于指定阈值的所有局部极小值作为分割点。当应用于不同的数据集时,这可能会导致分割不足或过度。基于此,提出了一种基于垂直直方图的超分割算法1,其中W和H分别表示图像文本行的宽度和高度。

图2直观地显示了经典分割[9]和过度分割之间的区别。显然,在过度分割中发现了更多的分割点,以确保包含所有真正的分割点。我们也可以看到,在经典分割中,欠分割或过分割是不可避免的。真正的分割位置将由以下段落详述的整个过程确定。

3.2基于几何信息的图形

该步骤以过分割结果为输入,以每个分割点为顶点,建立图像。为了建立顶点之间的连接,由于字符长宽比在一定范围内变化,为了在不损失效率的情况下优化计算,我们选择应用一些约束条件。这些限制是:

bull;如果裁切图像的纵向比在选定的间隔内,则顶点i连接到顶点j(jgt;i)。这意味着我们必须根据文本行的高度来计算字符的最小宽度和最大宽度。

bull;如果存在J的前顶点k(kge;i),且两者之间的垂直柱状图值均为零,则顶点i不能连接到顶点j(jgt;i)。换句话说,字符之间的空格将不被考虑。

3.3汉字识别

与英文图像字符识别任务不同,英文图像字符识别任务已经有了许多公共标记数据集,如[12,13,14],中文图像字符识别中没有任何可用的标记数据集。一个重要的原因是,由于汉字的类别太大,人们可能找不到这么多的数据来训练字符识别模型。基于此,我们自动生成训练数据集,并使用它们训练识别模型。如本文[23]所述,利用已有的数据集生成噪声标签数据,对模型容量进行测试,我们使用标准机器生成的汉字作为标签数据集,并利用所提出的方案对其进行噪声测试。具体如下。

首先选取4120个字符类别作为识别词汇,包括GB2312-1245扩展高频汉字3755个汉字、94个可打印的ASCII符号和26个标点符号。其次,从一组从新闻视频中随机抽取并从互联网上下载的灰度图像中随机抽取大量补丁作为背景,忽略像素方差较低(即包含少量纹理)的面片。最后,我们选择11种字体、5种不同大小和3种粗体度的组合来生成标准数据,每种字体都使用3种不同的背景进行噪声处理。共产生495个(每类案件数)times;4120个(所有类别案件数)样本。

在生成训练数据后,对8个方向梯度直方图的512d特征进行多层感知模型训练,识别器的结构由一个512d输入层、两个2048d隐藏的乙状结肠层和一个4120d的Softmax激活输出层组成。初始权重从范围内的均匀随机分布中得出[-0.05;0.05]。然后由识别系统对之前建立的图形中每个弧对应的每个裁剪图像进行处理,并保留与其概率相关的n个最佳结果。此步骤的结果作为图形权重计算器的输入提供。

3.4波束搜索确定

经识别步骤处理后,图中的每一个弧代表与裁剪图像相对应的n个最佳结果,因此用n个起点和终点相同但与其概率相关的特征不同的弧代替。然后,从顶点0开始一步一步到顶点9结束(以图1为例),进行网格的建立和修剪的动态过程。在此基础上,进行波束搜索以找到最佳路径。在从顶点i到i 1的每一步中,到达顶点i 1的每个拱门都由基于字符的3-gram语言模型进行处理。根据与拱门相对应的特征的不同历史(在我们的例子中只考虑了两个以前的特征),拱门再次被代表每个不同特征的许多拱门所取代。在每个单独的拱门中,记录识别概率rprob和3-gram语言概率lscore。拱门总分计算如下:

edgescorei,j = alpha; log(Rprob) (1 minus; alpha;) log(Lprob) (3)

这里,alpha;是语言得分和认知得分的比例,在我们的实验中等于0.9。由于每一个到达顶点i 1的不同字符都应用了3-gram语言模型,因此在顶点i 1上添加了相当多的拱门。因此,采用了一种修剪策略,提高了识别效率,同时保持了识别精度。只有到达顶点i 1的顶部m(在我们的例子中m设置为50)拱门是保留的,其他的都是修剪的。从起始顶点到顶点i 1通过k-th路径的总分定义如下:

totalscorei 1 k =sum;k edgescore/edge(k) (4)

其中sum;k edgescore表示k-路径中所有edgescore的总和,edge(k)表示k-路径中的总拱数,当进程到达终点顶点时,最大的totalscore路径将是最佳路径,最佳路径中与拱对应的字符将是识别结果。图1举例说明了整个识别方案。

4实验与结果分析

为了测试该方案的性能,我们在一个包含各种图像文本的数据集上进行了一系列的实验,这些图像文本分别从13个电视新闻视频中收集,并用其原始电视节目名称来表示每一组。它们每个大约30分钟长,彼此完全不同。由于视频中的同一文本将持续一段时间,因此只能手动剪切其中一个文本。而文本块的每一行都是单独标注和保存的,仅针对图像汉字字符串识别的问题。这些文本行图像具有不同的大小(17times;85、30times;378、49times;452)、不同的颜色、不同的字体和不同的字符间距,并且受到不同类型的失真。这包括复杂的背景、低分辨率、相似的前景背景色、不均匀的光线等。图3直观地显示了来自每个数据集的一些典型类型样本。表1显示了每个数据集的识别精度以及与之相关的其他细节参数,例如文本行的总数和字符的总数。数据集中分别有1131个文本行和12700个字符。

为了进行比较,我们使用ABBYY FineReader 10.0[11]测试所有数据集。作为一种商业OCR,ABBYY不仅可以识别文档图像,还可以识别普通图像中的文本,因此它分别作为第11届[12,13]和第12届[14]国际文档分析与识别会议上两个版本的强大阅读竞赛的基线系统。激烈的阅读竞争的任务是定位和识别图像中的英语单词。在我们的例子中,由于支持简体中文识别,因此中文字符串识别问题受到关注,ABBYY也适合作为基线系统。两种系统的识别精度如图4所示。结果表明,在图像文本行背景清晰、分辨率高的情况下,两种系统都能达到较高的性能,如在DFTV数据集中。但当应用于复杂背景和低分辨率的图像文本时,我们的系统比ABBYY更为强大。两种系统的平均识别精度分别为85.44%和53.59%。整个数据集的性能提高了59.4%。由于我们的方案直接识别灰度空间中的图像,并且只使用生成的数据来训练识别器,因此它对数据集的依赖性较小,而且在不同类型的图像文本中更容易转移。因此,它对复杂的背景图像文本的识别是非常强大的。

lt;

资料编号:[3748]