基于Hadoop系统的大数据分析外文翻译资料

2022-10-27 15:36:47

英语原文共 4 页,剩余内容已隐藏,支付完成后下载完整资料

基于Hadoop系统的大数据分析

摘要:在当今世界,越来越多的用户通过互联网上传数据,大规模的数据已经超过了传统的存储和分析技术所能承载的容纳范围。因此,有必要引入新的高效的大数据分析方法来从大数据中提取有用的信息,大数据几乎在所有领域都有着巨大的重要性,比如教育、医疗等,大数据被定义出三个主要特征,高容量、高速度、高品种。Hadoop系统提供了一个高效的大数据分析平台,是一个分布式的数据存储与处理的平台,使用文件系统 HDFS存储数据和计算框架MapReduce分析数据。

关键字:大数据,Hadoop,HDFS,MapReduce

1 引言

如今,大多数人在不同的社交网站都有自己的账号,如Facebook,Twitter,Instragram,Linkedln等。Facebook每月有13.93亿活跃用户,每日有8.9亿活跃用户,平均来说,每天有3.5亿张照片和47.5亿个商品在Facebook上分享。根据2014年11月的统计数据,Facebook平均每天存储300000TG的数据,新增600TG的数据[14],这些数据不会被删除,相反,它会随着速率的增加而增加,这些大量的数据被称为大数据。

“大数据就是比现有的传统的关系数据库和文件处理系统有更高容量、响应速度更快、品种更多的各种各样数据的集合。这些数据太大、移动太快,因此不适应RDBMS架构”[2]。大数据通常由三种类型构成,传统的企业数据、机器生成/传感器数据和社会数据。企业数据包括CRM、ERP、网上购物等产生的数据,机器生成器数据包括CDR、博客和智能电表等产生的数据,社会数据包括客户反馈流、社会媒体平台、博客等中产生的数据[5]。在当今世界,大数据对于医疗保健的大规模分析有很大的重要性。汇聚不同来源的所有相关医疗信息对于治疗病人有很大帮助,医生可以很容易地获得世界各地的疾病信息,还可以集成来自不同领域的数据,如临床数据、成本参与、管理数据、医药数据和开发数据、病人的行为和情绪数据等,有助于更有效地治疗病人[7]。2014年世界杯,大数据为德国获得冠军提供了一个竞争优势。一个名为SAP的德国软件公司构建了一个可以通过分析相机中的球场上的视频数据的称为匹配洞察的工具,球员的位置和速度这些成千上万的数据点都被发送到SAP数据库通过这个工具进行分析,教练能够参照分析结果对球员进行部署。不管是足球,还是其他体育运动,像篮球和网球,都可以使用大数据达到这些目的[11]。大数据能过处理大规模数据和及时要求,它有助于在规避纳税人风险和检测欺诈的基础上选择正确的策略,它还有助于税收审计人员实时搜索大量数据[15]。以业务为例,大数据不仅能在商业计划时被用于分析的得出重要的结论和见解,还能在应用程序开发中提供实时服务,造福客户[8]。同样的,大数据可以被各个领域广泛使用,如智能交通、金融交易、市场监测、控制、军事决策、早期自然灾害预警等[3]。

2 特点

大数据的特性可以被定义在“3V”,分别是容量、速度和多样。除此之外,大数据也具有其他的特性,如价值性、准确性、多变性和传播性,但是不经常具体定义大数据,因为它们也适用于平常的数据。

2.1 容量

“大数据”这个词本身指大的数据容量。当社交媒体中产生1TG的数据被添加到现有的1000TG的数据中,数据很快就会形成大的规模,随着数据规模的增加,很难使用传统的分析方法来分析这些数据,因此引入更有效的方法来分析大数据是很有必要的[1]。

2.2 速度

速度定义数据是因为数据处于运动状态。例如,可以从传感器或指定的网络日志中收集数据的输入速度,也可以捕获、存储和分析数据流的速度;另一个维度上来看,速度具有数据效用持久性,它指定了价值的长短,即数据是否有长久的价值或者很快就失去价值。除此之外,速度有一个三维空间,数据应该被存储或检索[10]。

2.3 多样

大数据的多样性是指数据具有不同的类型或来源。大数据不像只包括结构化数据的传统数据库那样,相反,他们也含有半结构化和非结构化数据,如电子邮件、文档、短信、视频、图片、音频、图形、输出传感器等。使用这些多样性的数据面临的挑战是如何快速地存储和检索数据,以及有效地从多个事件中提取相关数据[10]。

2.4 价值

大数据相比传统数据库提供的数据,更加实现个性化,能够使我们根据数据的价值对其进行排名。大数据存储数据本质是理解数据,如果大数据中的数据价值低,大量的数据也只会提供较小的信息[10]。

2.5 真实性

大数据能够真实地描述数据的出处,他显示了数据的来源是否可靠。因此,我们能够判断出检索的数据是否准确、完整[10]。

2.6 差异性

差异性显示出数据与可行的间隔性的报告是否一致,因此,我们可以知道大数据是重要的还是嘈杂的数据检索[10]。

2.7 病毒营销

数据传播的速度被定义为病毒营销,它显示了数据被其他活动拿起或重复的频率[10]。

3 大数据分析

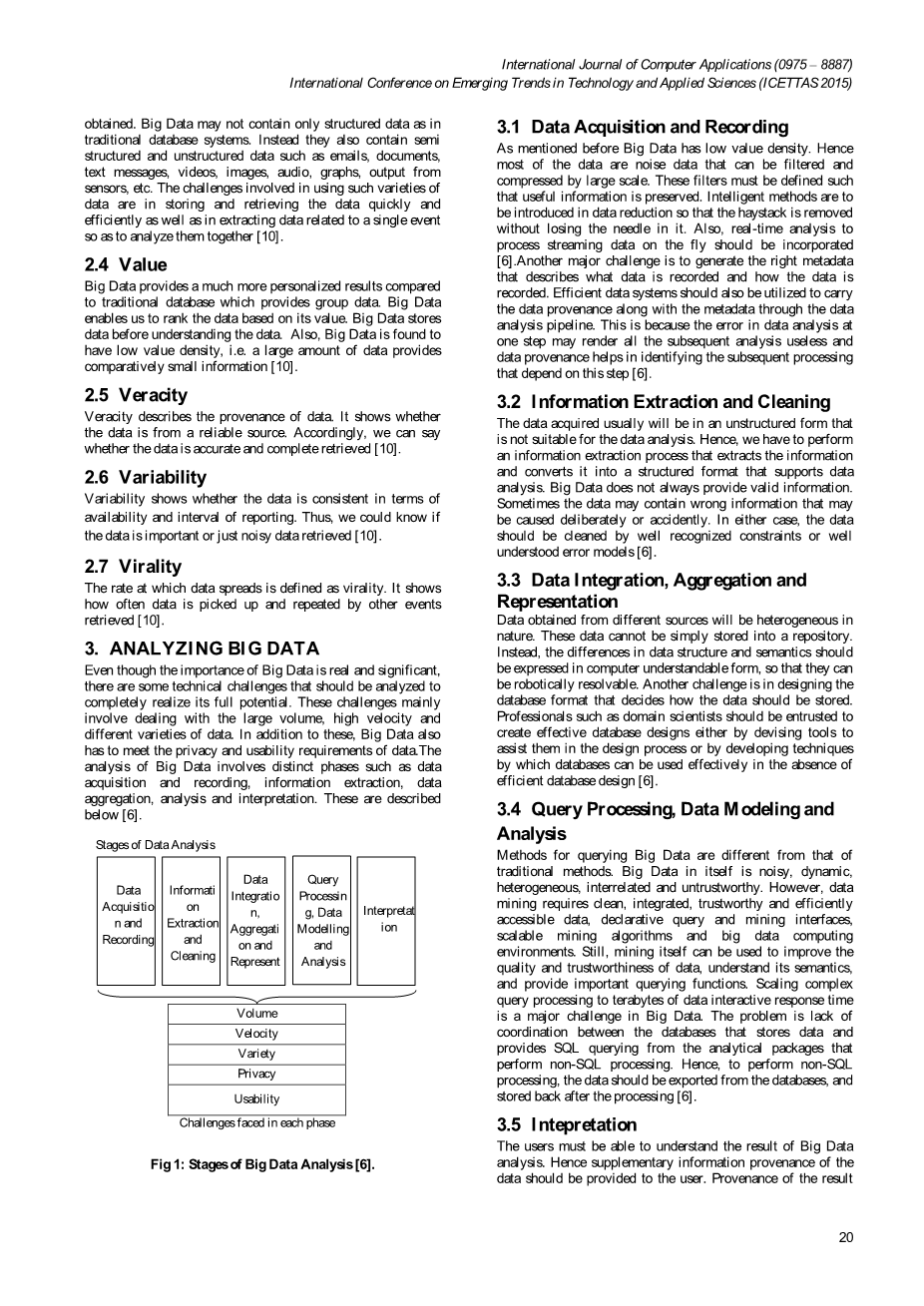

尽管大数据的重要性在于真实和有意义,但有些技术挑战应该被分析来实现其全部潜力。这些挑战主要涉及处理大容量、高速度、不同种类的数据。除了这些,大数据必须满足数据的隐私性和可用性需求。大数据的分析涉及数据不同的阶段,如采集和记录、信息提取、数据聚合、分析和解释,下面就是相应描述[6]。

图1 大数据分析阶段

3.1 数据采集和记录

正如前面提到过的大数据价值密度低,大部分的数据都可以通过大规模的压缩过滤噪音数据,这些过滤器必须保留有用信息。明智的方法被用来简化数据,这样无用数据被过滤而不失去有用部分。同时,实时分析动态流程应该合并。另一个主要挑战是生成正确的元数据,用以记录数据。高效的数据系统也应该通过数据分析管道来利用数据来源和元数据,这是因为在数据分析时错一步后面的分析都将变得毫无用处,数据来源有助于确定后续处理。

3.2 信息提取和清洁

获得的数据通常呈现出非结构化的形式,不利于数据分析,因此,我们必须执行一个信息提取过程,提取信息然后将它转换成一个结构化的格式,用以支持数据分析;大数据并不总是提供有效信息,有时因为故意或不小心造成数据可能包含错误的信息。在上面两种情况下,数据应由公认的约束条件或好的辨认错误模型来进行提取和清理。

3.3 数据集成、聚合和表示

从不同来源获得的大数据具有异构性。这些数据不能简单地存储在一个存储库中,相反,数据以计算机可以理解的数据结构或语义差异形式存在时,他们可以被智能化解决。另一个挑战是设计数据库格式,决定如何存储数据。科学家应该委托该领域的专业人士,通过设计工具来创建有效的设计,帮助他们在设计或开发技术时,能够有效地进行数据库设计。

3.4 查询处理、数据建模和分析

大数据的查询方法不同于传统方法,大数据本身是复杂的、动态的、异构的、相关联的和不可靠的,然而数据的挖掘需要综合有效部分,要能够有效安全地访问数据,声明查询和挖掘接口,具有伸缩的挖掘算法和大数据计算环境。不过,挖掘本身可以用来改善质量提高数据的可信度,了解其语义,并提供重要的查询功能。在大数据中,扩展兆兆字节的数据在查询处理的交互响应时间是一个大的挑战,问题是存储数据的数据库和提供SQL的分析软件之间缺乏执行非SQL处理。因此,应该从数据库导出数据存储后加工执行非SQL处理。

3.5 解释器

用户必须能够理解大数据的结果分析,因此信息的出处数据作为补充应提供给用户。出处可以解释输出结果是基于什么而获得的。捕获、存储和查询出处以及元数据,允许用户创建一个基础设施,这样不仅能解释结果,而且可以在重复的分析中获得不同的假设、参数和数据集。

4 Hadoop

Hadoop是一个由Apache软件公司提供并由Doug Cutting进行大规模数据存储和分析的开源框架。因此,这是一个用来存储和分析大数据的重要工具。Hadoop主要由被称为HDFS的分布式文件系统和名为MapReduce的软件框架组成,除此之外,Hadoop有许多其他组件,如HBase、Pig、Hive等。HBase是面向列的分布式数据库,使用HDFS的底层存储,他同事支持批处理方式,用MapReduce进行计算和点查询。Hive是一个分布式数据仓库,使用基于SQL的查询语言管理HDFS数据。Pig基于HDFS和MapReduce运行,提供了一个数据流语言和环境处理大型数据集。Hadoop0.20版本和1.x系列使用Kerberos身份验证授权对Hadoop数据进行访问,Hadoop0.22版本和2.x系列使用一个名为MapReduce 2运行YARN(另一个资源谈判代表)。

4.1 Hadoop分布式文件系统(HDFS)

Hadoop的HDFS是存储单元,这是一个分布式文件系统,用于存储大尺寸、非结构化、流媒体数据。HDFS具有较高的容错性,在硬件的部署上也具有低成本性。HDFS还提供大量的大尺寸吞吐量访问应用程序数据。为了使流媒体文件系统数据进行访问,HDFS简化了一些POSIX需求。

图2:HDFS架构

HDFS主/从体系结构有两种类型的节点,它由一个名字字节充当主和许多数据字节充当从。名字字节管理文件和调节访问文件系统名称空间,集群中通常由一个数据节点,数据字节管理存储数据在节点上运行。一旦HDFS暴露一个文件系统,用户可以用文件存储数据,每个文件由内部分割成一个或多个数据节点块存储。每个块的默认大小为64MB;字节点执行文件系统名称空间操作,如打开、关闭、重命名文件和数据节点目录以及映射块。数据节点执行客户的读写请求,并从名字节点接收指令,执行块创建、删除和复制。HDFS是用Java建立,因此,名字节点、数据节点可以在任何支持Java的系统中运行。

4.2 MapReduce

Hadoop MapReduce是一个用于在大型集群编写应用程序来处理大型数据集并行的变成范式。顾名思义,MapReduce程序在映射和减少两个阶段执行,MapReduce用工作跟踪和任务跟踪器执行任务。工作追踪的主任务是将映射和减少任务分配到不同的任务跟踪器中,然后任务跟踪器执行分配给它的工作。MapReduce是在客户端跟踪项目提交的任务配置工作时开始的,任务配置指定map和reduce函数的输入输出路径以及数据检索和存储。从输入路径,追踪工作确定输入的数量并选择任务追踪器来执行任务;在映射阶段,任务追踪器读取输入的数据,将其转换成lt;键,值gt;和内存存储缓冲区。一个周期性唤醒过程将内存缓冲区分类,并将其基于键值存储在本地文件R中(R是减数机节点的数量)。一旦地图任务完成,任务追踪器就会通知工作跟踪工作已完成。

图3:MapReduce架构

当任务追踪完成工作,跟踪工作为选定的任务追踪器分配减少任务。在减少阶段,每个任务跟踪器读取lt;键,值gt;并对本地文件中的键执行reduce函数,再将每对lt;键,聚合值gt;存储到输出文件。跟踪器追踪工作每个阶段的进展,它还发出周期性的信号来获取健康状况。如果有任务跟踪器崩溃了,追踪工作将任务分配到别的任务跟踪器。

5 环境

本课题是使用Amazon EC2服务器建立一个Hadoop集群,使用14.04LTS ubtuntu系统,使用t2.micro为实例类型。Hadoop1.2.1是安装在每个服务器,需要设置多个节点,其中名字字节是主节点,使用任务追踪器,数据节点和工作追踪是工作节点,其中一个工作节点是二级名字节点。Hadoop集群测试使用字数和pi;来计算得出结果。

6 总结

综上,已经证明了大数据在教育、体育、医疗等不同领域进行大规模数据分析的重要性。如果进行正确地存储和分析,大数据几乎可以在这些领域发挥大的成效。大数据的分析包括在不同阶段进行数据采集、数据记录、信息提取、数据清理、数据集成、数据聚合、数据查询、数据建模和数据分析。基于HFDS和MapReduce的Apache Hadoop提供了一个有效的框架来分析大数据。在未来,我们可以编写出不同的MapReduce程序来进行大数据分析,我们也能编辑Hadoop源代码来提高Hadoop性能。

7 参考文献

[1] Avita et al, “Big Data: Issues, Challenges, Tools and Good Practices,” in IEEE Sixth International Conference on Contemporary Computing, 2013, pp. 404-409.

[2] Raymond Gardiner Goss and KousikanVeeramuthu,“Heading Towards Big Data Building a Better Data Warehouse for more data, more speed and more users,” in IEEE 24th Annual SEMI Advanced Semiconductor Manufacturing Conference, 2013, pp. 220-225.

[3] Nader Mohamed and Jameela Al-Jaroodi, “Real-Time BigData Analytics:Applications and Challenges,” in IEEE International Conference on High PerformanceComputing and Simulation, 2014, pp. 305-310.

[4] Tom White, “Meet Hadoop, ” in Hadoop: The definitive guide, 3rd Edition, Californi

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[153300],资料为PDF文档或Word文档,PDF文档可免费转换为Word